Apakah kecerdasan buatan mewakili ancaman eksistensial terhadap umat manusia seperti perang nuklir dan pandemi? Sebuah pernyataan baru yang ditandatangani oleh ilmuwan AI dan tokoh terkenal lainnya mengatakan bahwa hal tersebut harus diperlakukan seperti itu.

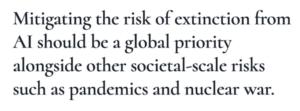

Pernyataan itu berbunyi: “Mengurangi risiko kepunahan AI harus menjadi prioritas global bersama dengan risiko skala sosial lainnya seperti pandemi dan perang nuklir.” Pernyataan 22 kata tersebut diterbitkan oleh Center for AI Safety (CAIS), sebuah organisasi nirlaba yang berbasis di San Francisco yang mengatakan pernyataan tersebut ditujukan untuk membuka diskusi global tentang risiko mendesak AI.

Menempati daftar penandatangan adalah Geoffrey Hinton, seorang perintis penelitian AI yang baru-baru ini meninggalkan Google untuk memiliki lebih banyak kebebasan untuk membunyikan alarm mengenai apa yang dia sebut bahaya yang jelas dan hadir yang disajikan oleh AI, dengan mengatakan, "Hal-hal ini semakin pintar dari kita."

Hinton adalah salah satu penemu metode pembelajaran mendalam yang digunakan oleh model bahasa besar seperti GPT-4, bersama dengan sesama endorser Yoshua Bengio. Yang paling absen dari daftar adalah anggota ketiga dari tim peneliti pemenang Turing Award Yann LeCun, kepala ilmuwan AI di Meta.

Pernyataan itu juga ditandatangani oleh beberapa CEO dari pemain AI utama termasuk Sam Altman dari OpenAI, Demis Hassabis dari Google DeepMind, dan Dario Amodei dari Anthropic.

Bagian dari situs web CAIS mencantumkan potensi risiko AI termasuk persenjataan, kesalahan informasi, penipuan, perilaku mencari kekuatan, dan banyak lagi. Mengenai kemungkinan upaya AI untuk merebut kekuasaan, situs web tersebut mengatakan: “AI yang memperoleh kekuatan besar dapat menjadi sangat berbahaya jika tidak sejalan dengan nilai-nilai kemanusiaan. Perilaku mencari kekuatan juga dapat memberi insentif pada sistem untuk berpura-pura selaras, berkolusi dengan AI lain, mengalahkan monitor, dan sebagainya. Dalam pandangan ini, menciptakan mesin yang lebih kuat dari kita adalah bermain api.”

Organisasi tersebut juga menegaskan bahwa membangun AI yang haus kekuasaan ini dapat didorong oleh para pemimpin politik yang melihat keunggulan strategisnya, mengutip Vladimir Putin yang mengatakan, “Siapa pun yang menjadi pemimpin [AI] akan menjadi penguasa dunia.”

Pernyataan CAIS menandai yang terbaru dari serangkaian inisiatif profil tinggi yang berfokus pada penanganan keamanan AI. Di awal tahun, sebuah surat terbuka yang kontroversial ini didukung oleh beberapa orang yang sama yang mendukung peringatan saat ini mendesak jeda enam bulan dalam pengembangan AI yang disambut dengan reaksi beragam dalam komunitas ilmiah. Kritikus berpendapat bahwa surat tersebut melebih-lebihkan risiko yang ditimbulkan oleh AI atau, sebaliknya, mereka setuju dengan potensi risikonya tetapi tidak setuju dengan solusi yang diusulkan.

The Future of Life Institute (FLI) menulis surat terbuka sebelumnya dan mengatakan ini tentang pernyataan CAIS: “Meskipun FLI tidak mengembangkan pernyataan ini, kami sangat mendukungnya, dan percaya kemajuan dalam mengatur teknologi nuklir dan biologi sintetik bersifat instruktif. untuk memitigasi risiko AI.”

FLI merekomendasikan serangkaian tindakan dalam mengurangi risiko ini termasuk mengembangkan dan melembagakan perjanjian internasional untuk membatasi proliferasi AI yang berisiko tinggi dan memitigasi risiko AI tingkat lanjut, serta mendirikan organisasi antar pemerintah, mirip dengan Badan Energi Atom Internasional (IAEA), untuk mempromosikan penggunaan AI secara damai sambil memitigasi risiko dan memastikan pagar pembatas ditegakkan.

Beberapa ahli menyebut surat terbuka ini salah arah dan bahwa AGI, atau sistem otonom dengan kecerdasan umum, bukanlah masalah yang paling mendesak. Emily Bender, seorang profesor linguistik komputasi di University of Washington dan anggota tim etika AI terkenal yang dipecat oleh Google pada tahun 2020, mengatakan dalam sebuah tweet bahwa pernyataan tersebut adalah “tembok rasa malu di mana orang secara sukarela menambahkan nama mereka sendiri. ”

“Kita harus prihatin dengan kerugian nyata yang dilakukan [korporasi] dan orang-orang yang mengarangnya atas nama 'AI', bukan [tentang] Skynet,” tulisnya.

Salah satu kerugian ini dapat dilihat pada contoh saluran bantuan gangguan makan yang baru-baru ini memecat tim manusianya untuk menggunakan chatbot bernama Tessa. Saluran bantuan telah aktif selama 20 tahun dan dijalankan oleh National Eating Disorder Association. Sebuah laporan dari Vice mencatat bahwa setelah pekerja NEDA pindah ke serikat pekerja awal bulan lalu, asosiasi tersebut mengumumkan akan mengganti saluran bantuan dengan Tessa sebagai sistem pendukung utama grup.

Tessa dinonaktifkan oleh organisasi hanya dua hari sebelum diambil alih karena chatbot mendorong perilaku merusak yang dapat memperburuk gangguan makan, seperti sangat membatasi kalori dan menimbang diri sendiri setiap hari.

'Berita' 카테고리의 다른 글

| 15 Game FPS Seluler Terpopuler Saat ini (0) | 2023.11.01 |

|---|---|

| Apa itu ISO dalam Fotografi? Apa Fungsinya? (0) | 2023.09.01 |

| Google Mengklaim TPU v4-nya Mengungguli Nvidia A100 (0) | 2023.06.07 |

| Cloudera: Melayani lebih dari 25 Juta Terabyte Data (0) | 2023.06.07 |

| Intel Meluncurkan Prosesor Workstation Xeon Baru (0) | 2023.06.07 |